A história da informática é uma narrativa fascinante que se estende por séculos e reflete a evolução das tecnologias de processamento de informações. Ela começa muito antes do surgimento dos primeiros computadores, com avanços graduais ao longo do tempo.

A informática é a ciência que envolve o estudo e desenvolvimento de métodos e técnicas de processamento, armazenamento e transmissão de informações por meio de sistemas computacionais.

Através da informática, é possível desenvolver softwares para automatizar tarefas, criar algoritmos que otimizam processos, analisar grandes volumes de dados para extrair informações valiosas, construir sistemas de comunicação eficientes e muito mais. Ao longo dos anos, a informática tem revolucionado a maneira como vivemos, trabalhamos e nos conectamos.

Neste texto, embarcaremos em uma jornada pelo mundo da informática, explorando desde os primórdios até os avanços contemporâneos que redefiniram a maneira como interagimos, comunicamos e compreendemos o nosso entorno. É uma excelente oportunidade para refletir sobre a importância da tecnologia e como ela pode contribuir para a melhoria de vida das pessoas.

Origem do Dia da Informática

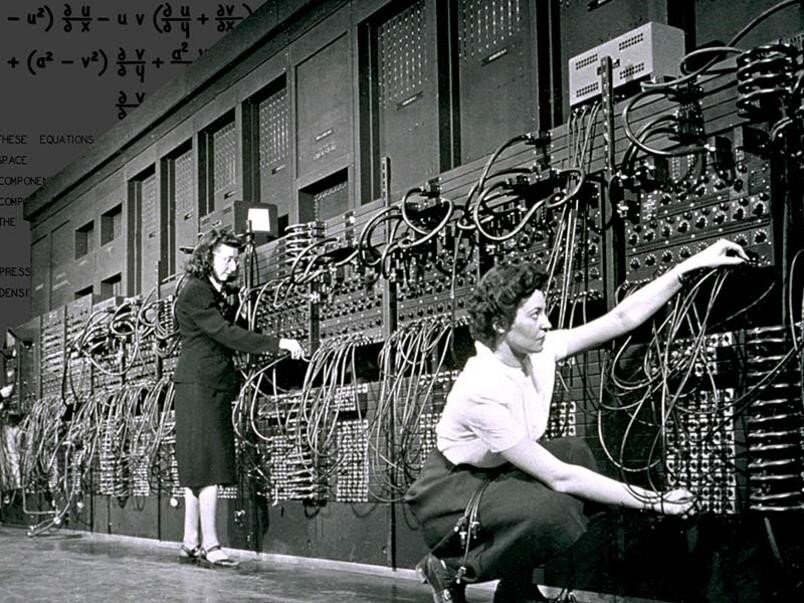

O Dia da Informática é comemorado no dia 15 de agosto, uma data de celebração que destaca a importância da tecnologia da informação na sociedade moderna. A data marca a apresentação do primeiro equipamento eletrônico chamado de computador no mundo, o ENIAC (Electronic Numerical Integrator Analyzer and Computer), em 1943, nos Estados Unidos pelos cientistas John Atanasoff e Clifford Berry.

O aparelho foi encomendado para fins militares durante a Segunda Guerra Mundial, e tinha o objetivo de executar cálculos complexos com velocidade e precisão, sendo inicialmente desenvolvido para auxiliar em cálculos balísticos e outros problemas matemáticos relacionados a guerra. Sua construção envolveu uma série de avanços tecnológicos, incluindo a utilização de válvulas eletrônicas (também conhecidas como tubos de vácuo) para realizar operações lógicas e aritméticas.

O ENIAC foi oficialmente apresentado ao público em 1946, pelos engenheiros John Mauchly e John Eckert na Universidade da Pensilvânia, nos Estados Unidos. O aparelho foi utilizado para uma variedade de tarefas de pesquisa científica e cálculos complexos. Sua influência foi imensa, demonstrando a viabilidade da computação eletrônica e abrindo caminho para o desenvolvimento de computadores mais avançados.

História da Informática

Se formos considerar a palavra “computador”, no qual tem sua origem no latim “computare”, que significa “calcular” ou “contar”, devemos voltar à idade antiga, quando os seres humanos começaram a desenvolver métodos para realizar cálculos e processar informações. Desta forma, uma das primeiras máquinas de computar desde cerca de 3000 a.C, foi o ábaco, um instrumento mecânico de origem chinesa criado para realizar cálculos simples. Assim, ele é considerado o “primeiro computador”, pois realizava operações algébricas.

No século XVII, uma série de dispositivos mecânicos foi desenvolvida por matemáticos e inventores. Entre eles, destaca-se a Máquina de Pascal, criada no início da década de 1640, que representou um dos primeiros dispositivos mecânicos capazes de executar cálculos aritméticos. Essa máquina operava por meio de uma série de rodas dentadas que, ao serem giradas manualmente, permitiam a adição ou subtração de números. Posteriormente, na década de 1670, o matemático e filósofo alemão Gottfried Wilhelm Leibniz desenvolveu o primeiro sistema de numeração binário conhecido como “Roda de Leibniz”. Considerada a primeira calculadora de bolso, tinha a capacidade de realizar operações de adição, subtração, multiplicação e divisão, utilizando um sistema de engrenagens como base para suas operações.

Linha do Tempo

A partir destes acontecimentos então, as evoluções foram acontecendo de forma constante e em ritmo mais acelerado.

Século XIX

Teares Automatizados de Jacquard – Em 1801, o mecânico francês Joseph-Marie Jacquard criou teares automatizados que utilizavam cartões perfurados para controlar padrões de tecelagem. Esses cartões perfurados são considerados um precursor dos sistemas de codificação e processamento de dados.

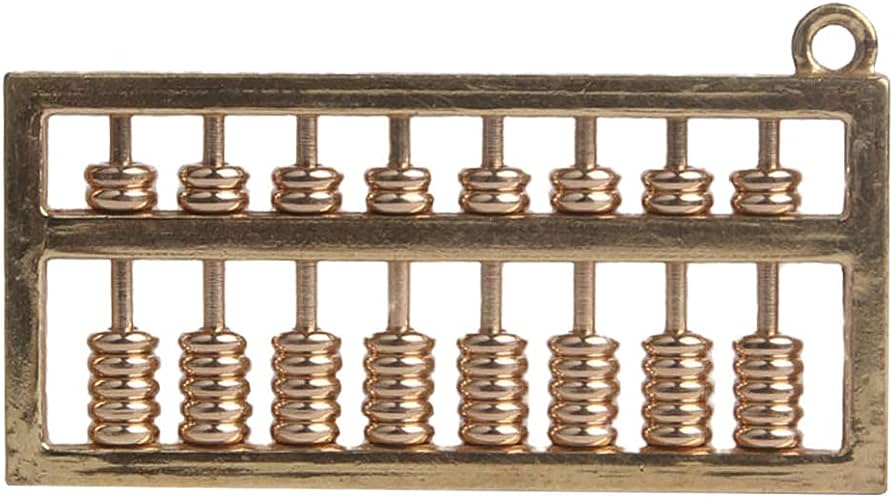

Máquina Analítica de Babbage – Em meados do século XIX, Charles Babbage projetou uma máquina de calcular movida a vapor que seria capaz de calcular tabelas de números. A invenção foi considerada o primeiro projeto de um computador programável. Embora nunca tenha sido construída durante sua vida, suas ideias estabeleceram os fundamentos conceituais para a computação.

Primeiro Programa de Computador – Ada Lovelace, matemática inglesa escreveu o primeiro programa do mundo enquanto traduzia um artigo sobre a “Máquina Analítica” de Babbage. Ela produziu inúmeras notas que incluíam o que é considera o primeiro algoritmo processador por uma máquina. Este fato, faz com que Lovelace seja considerada a primeira programadora da história.

Tabulação Estatística – No final do século XIX, o engenheiro estadunidense Herman Hollerith desenvolveu uma máquina de tabulação estatística baseada em cartões perfurados. Essa inovação foi usada para processar dados do censo nos Estados Unidos em 1890, agilizando o processo e estabelecendo a base para futuras tecnologias de processamento de dados.

Início do Século XX

Analisado Diferencial – Em 1931, o engenheiro e cientista Vannevar Bush contribuiu com a criação do “Differential Analyzer”, um dispositivo mecânico que podia resolver equações diferenciais complexas, sendo um dos primeiros exemplos de computação analógica.

Máquina de Turing – Em 1936, o matemático britânico Alan Turing, considerado atualmente como o “Pai da Computação”, apresentou uma das contribuições mais significativas para a história da informática: o conceito da “Máquina de Turing”. Esta máquina, embora fosse um modelo teórico, definiu os fundamentos matemáticos da computação e da teoria da computabilidade.

Atanasoff-Berry Computer – O físico norte-americano John Atanasoff e o engenheiro Clifford Berry construíram o “Atanasoff-Berry Computer” (ABC) em 1941. Embora não fosse um computador digital completo, foi o primeiro computador a armazenar informações em sua memória principal.

Computador Elétrico Z3 – Ainda em 1941, durante a Segunda Guerra Mundial, houve um impulso significativo no avanço da tecnologia de computação. Países ao redor do mundo passaram a investir recursos na criação de seus próprios computadores. Na Alemanha, Konrad Zuse emergiu como pioneiro, construindo o Z3, o primeiro computador programável. Conhecido como “Computador Elétrico Z3”, esse dispositivo possuía uma memória com capacidade para armazenar até 64 números.

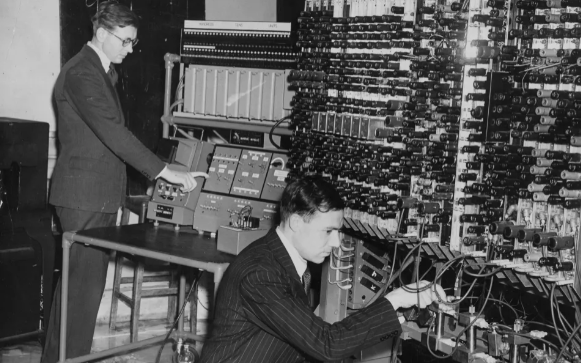

ENIAC – Foi desenvolvido entre 1943 e 1945 na Universidade da Pensilvânia, nos Estados Unidos. O ENIAC (Electronic Numerical Integrator and Computer) foi construído com o objetivo de acelerar os cálculos balísticos para a Segunda Guerra Mundial. Este gigante era um omputador digital eletrônico de grande escala, com mais de 17.000 válvulas eletrônicas (tubos de vácuo) que realizavam operações lógicas e aritméticas. Sua unidade central ocupava um espaço de cerca de 30 metros de comprimento e 2,4 metros de altura, preenchendo uma sala inteira. O ENIAC era extremamente rápido comparador com as tecnologias anteriores e desempenhou um papel crucial na evolução da informática.

UNIVAC – Após deixarem a Universidade da Pensilvânia em 1946, os protagonistas-chaves no desenvolvimento do ENIAC, John Mauchly e John Eckert fundaram o Census Bureau para criarem o UNIVAC, o primeiro computador comercial para empresas e aplicações governamentais representando uma transição fundamental da pesquisa acadêmica para a aplicação prática dos computadores.

Transistores – Ainda na primeira metade do Século XX, os transistores substituíram as válvulas, tornando os computadores mais compactos e eficientes. William Shockley, John Bardeen e Walter Brattain do Bell Laboratories inventam o transistor, feito que marca a 2ª geração de computadores. Na época, o transístor conseguia fazer 10 mil vezes mais processamentos que a válvula.

Final do Século XX

Linguagem COBOL – Em 1953, a analista de sistemas da Marinha dos Estados Unidos, Grace Hopper, foi a responsável pelo desenvolvimento da linguagem de programação de alto nível voltada para o mercado corporativo, COBOL (Common Business-Oriented Language). O COBOL é uma linguagem compilada, flexível e segura, e com uma capacidade de processamento considerável.

Linguagem FORTRAN – Em 1954, o matemático e cientista da computação John Backus liderou uma equipe de programadores da IBM para desenvolver uma linguagem de programação revolucionária chamada FORTRAN (Formula Translation) projetada para cálculos científicos e engenharia. Essa linguagem inovadora introduziu conceitos como variáveis, loops e sub-rotinas, e possibilitou uma maneira mais acessível de criar softwares voltados para cálculos complexos.

Circuito Integrado – O primeiro chip foi inventado por Jack Kilby e Robert Noyce em 1958. Um marco significativo na história da informática, pois este evento se refere a invenção do microchip, uma pequena peça de silício que continha múltiplos componentes eletrônicos em uma única estrutura compacta. Esse avanço permitiu que a eletrônica fosse miniaturizada de maneira sem precedentes.

Protótipo do Computador Moderno – Douglas Engelbart, um engenheiro e pesquisador de computação, liderou a equipe do Stanford Research Institute (SRI) que desenvolveu o que ficou conhecido como “The Mother of All Demos” (A Mãe de Todas as Demonstração). Em 1964, Douglas apresentou um protótipo de computador moderno, que contava com mouse e uma interface gráfica do usuário. Esse marco importante possibilitou que a tecnologia fosse mais acessível ao público em geral.

ARPAnet – Ou, Advanced Research Projects Agency Network, foi desenvolvida em 1969 pelo Departamento de Defesa dos Estados Unidos. A ARPAnet foi a primeira rede de computadores a implementar a troca de informações entre os vários centros de pesquisa que participavam de projetos da ARPA para trocar informações e compartilhar recursos. O sucesso da ARPAnet levou à expansão da rede e eventualmente à criação da Internet que conhecemos hoje.

Intel 1103 – Lançado em 1970 pela Intel, o primeiro chip de memória dinâmica de acesso (DRAM), comercialmente viável impulsionou a capacidade de armazenamento e processamento dos computadores.

Disquete – Um time de engenheiros da IBM liderados por Alan Shugart inventam o disquete, a primeira forma de compartilhamento de dados entre computadores, tornando o transporte e compartilhamento de informações mais práticos.

Ethernet – Robert Metcalfe e sua equipe desenvolveram o protocolo Ethernet no Centro de Pesquisa de Palo Alto da Xerox em 1973. A ideia inicial era criar uma forma eficiente de conectar computadores dentro do laboratório, permitindo a troca de dados entre máquinas remotas de maneira mais rápida e confiável. Metcalfe desenvolveu um protocolo que utilizava colisões controladas de transmissão para garantir a integridade dos dados e a eficiência do compartilhamento de informações. Este evento desencadeou uma revolução na maneira como os dispositivos se comunicam, compartilham informações e acessam recursos em redes de computadores.

Microprocessador 8080 – Lançado pela Intel em 1975, sucedeu com sucesso o Intel 8008, introduzindo um chip de 8 bits com um conjunto abrangente de instruções e velocidades de clock de até 2 MHz. Foi aclamado como “o primeiro microprocessador verdadeiramente utilizável” e se tornou conhecido por equipar o MITS Altair 8800, o pioneiro computador pessoal da história. No mesmo ano, diversos modelos de computadores chegaram ao mercado, incluindo o Scelbi, IBM 5100, Commodore PET, entre outros.

Microsoft – Após o sucesso do Altair 8800, Paul Allen e Bill Gates, se ofereceram para escrever um software para o microcomputador, usando a nova linguagem BASIC. Em 4 de abril, após o êxito dessa primeira empreitada, os dois amigos de infância fundam sua própria empresa de software, a Microsoft.

Apple I e II – Em 1976, Steve Jobs e Steve Wozniak lançaram o Apple I, um computador pessoal montado manualmente que revolucionou a indústria da tecnologia. O Apple I foi um marco por ser um dos primeiros computadores a serem vendidos como uma placa de circuito completamente montada com memória RAM de 8KB e processador de 1MHz. Seu sucesso levou ao lançamento do Apple II no ano seguinte, em 1977, um computador mais avançado e com melhorias significativas em relação ao primeiro modelo, principalmente na aparência. Com uma carcaça branca de plástico e um teclado acoplado, a máquina contava com a possibilidade de aumentar a quantidade de memória RAM.

Acorn (IBM PC) – O primeiro computador pessoal da IBM, renomeado como IBM PC, foi lançado no mercado em 12 de agosto de 1981 a um preço de US$ 1.565. A sigla “PC” representava “computador pessoal”, consolidando a IBM como pioneira na popularização desse termo amplamente utilizado atualmente. O sistema contava com o sistema operacional MS-DOS da Microsoft. Além disso, o conjunto incluía um monitor, uma impressora, duas unidades de disquete, memória adicional, um adaptador para jogos e outras características.

Computador Portátil – Após Steve Jobs apresentar o primeiro computador pessoal comercial com uma interface gráfica de usuário (GUI), em 1983, o Gavilan SC, desenvolvido por Manuel (Manny) Fernandez, é lançado e anunciado como o primeiro computador portátil com design flip-form, sendo considerado o primeiro laptop da história.

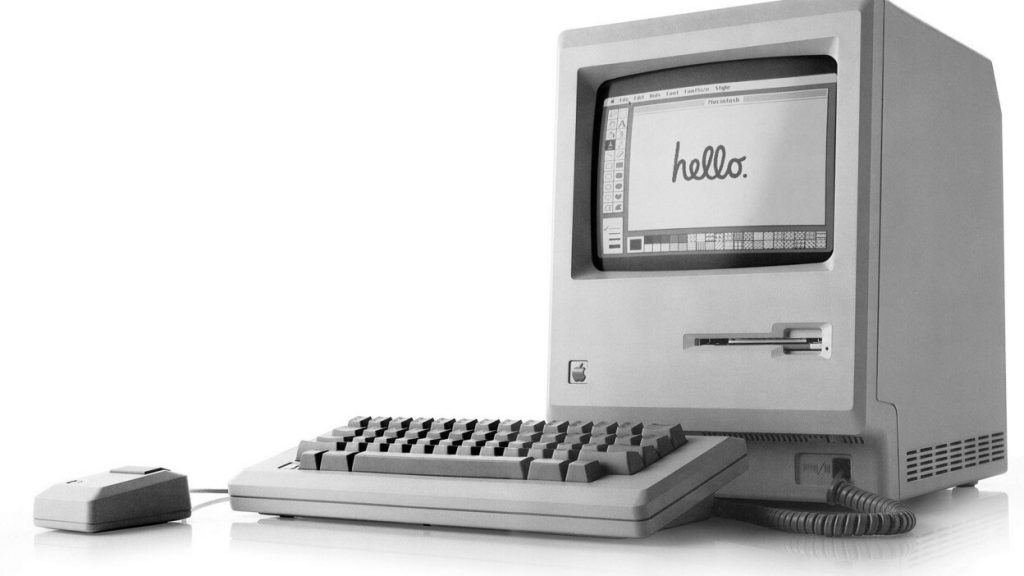

Apple Macintosh – O lançamento do Macintosh foi por meio de um icônico comercial durante o Super Bowl em 1984. No valor de US$2.500, foi o primeiro computador a popularizar a interface gráfica do usuário (GUI) e o mouse como principais meios de interação. O lançamento do Macintosh marcou a transição de computadores apenas para profissionais para dispositivos práticos e intuitivos, moldando o cenário tecnológico e tornando a computação acessível a um público mais amplo.

Windows 1.0 – Lançado em 1985, o Windows 1.0 marcou o início de uma nova era nos sistemas operacionais. Antes dele, os sistemas operacionais eram predominantemente baseados em texto, mas o Windows 1.0 introduziu uma interface gráfica sobre o modo texto (MS-DOS), permitindo interações sem a necessidade de comandos de terminal. Embora possa parecer simples e ultrapassado agora, foi pioneiro ao introduzir conceitos comuns hoje, como menus que se desdobram ao serem clicados, o uso de um cursor para apontar e clicar, barras de rolagem e janelas.

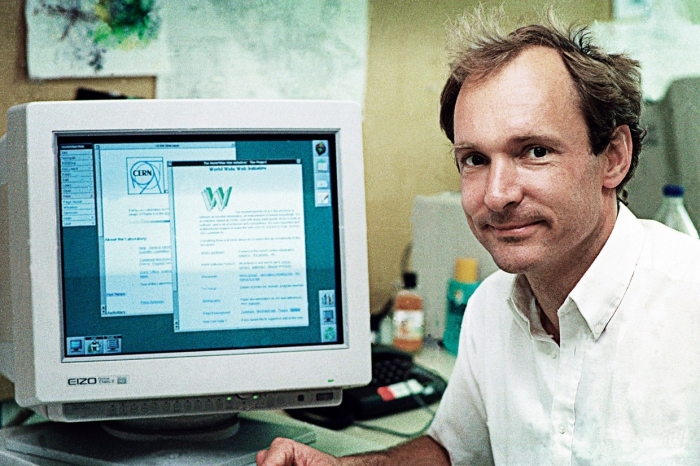

World Wide Web – Em 1989, o cientista britânico Tim Berners-Lee desenvolveu o conceito da “WWW” enquanto trabalhava no CERN, um laboratório de pesquisa nuclear na Suíça. Ele projetou um sistema que permitia a interconexão de documentos por meio de hiperlinks, criando uma teia global de informações acessíveis através da internet. Berners-Lee também desenvolveu a primeira linguagem de marcação para a criação de páginas web, o HTML, e o primeiro servidor web, bem como o primeiro navegador web chamado WorldWideWeb.

Formato PDF – O formato PDF foi desenvolvido pela Adobe Systems em 1993. Seu principal objetivo era criar um formato de arquivo universal que preservasse a integridade visual e o layout dos documentos em diferentes sistemas de computador, software e impressoras. Antes do PDF, compartilhar documentos eletronicamente geralmente levava a problemas de formatação, pois vários softwares e dispositivos interpretavam os arquivos de maneira diferente.

Google – Em 1996, Sergey Brin e Larry Page, estudantes da Universidade de Stanford, desenvolveram um algoritmo de pesquisa revolucionário que classificava páginas da web com base na relevância dos links que as conectavam. Isso resultou em resultados de pesquisa mais precisos e úteis, tornando o Google rapidamente o mecanismo de busca preferido para milhões de usuários.

Wi-Fi – A partir de 1999, o padrão de rede de rádio de curto alcance (IEEE 802.11b) foi rebatizado de “Wi-Fi” pela empresa Wi-Fi Alliance. O termo começou a se popularizar, marcando um momento crucial na evolução das tecnologias de redes sem fio. À medida que dispositivos como laptops e smartphones passaram a ser equipados com recursos de conectividade sem fio, o termo “Wi-Fi” se tornou sinônimo de acesso à internet sem fio e conectividade rápida em locais públicos e residenciais.

Século XXI

USB Flash Drive – No cenário tecnológico, o lançamento do USB Flash Drive no início do século, introduziu um novo modelo de armazenamento portátil. Essa pequena e prática unidade de armazenamento permitia que os usuários transportassem grandes quantidades de dados de maneira conveniente e rápida, eliminando a necessidade de CDs ou disquetes.

Sistemas Operacionais – No ano de 2001, a Apple apresentou o Mac OS X, uma evolução significativa do sistema operacional da Apple, caracterizado por sua interface elegante e funcionalidades avançadas. A Microsoft, por sua vez, lançou o Windows XP, um sistema operacional que trouxe estabilidade, segurança e uma interface mais amigável para os usuários. Esses lançamentos marcaram a progressão das interfaces gráficas de usuário e dos recursos operacionais, moldando a forma como interagimos com nossos computadores.

Athlon 64 – Em 2003, um novo marco na computação foi atingido com o lançamento do primeiro processador comercial de 64 bits trouxe um aumento significativo na capacidade de processamento. Este acontecimento teve um impacto profundo em campos como, design gráfico, jogos, simulações científicas e outros.

Firefox 1.0 – O ano de 2004 testemunhou o lançamento do Firefox 1.0, um navegador que desafiou a supremacia do Internet Explorer. Sua ênfase na segurança, velocidade e personalização atraiu muitos usuários, promovendo a competição saudável no mercado de navegadores e incentivando a inovação contínua na experiência de navegação na web.

Amazon Web Services – A revolução na computação em nuvem começou em 2006 com o lançamento do Amazon Web Services (AWS) pela Amazon. Essa plataforma pioneira forneceu uma maneira flexível e escalável de fornecer serviços e recursos de TI pela internet. O AWS não apenas revolucionou a infraestrutura de TI para empresas, mas também permitiu o surgimento de novos modelos de negócios e aplicativos baseados em nuvem.

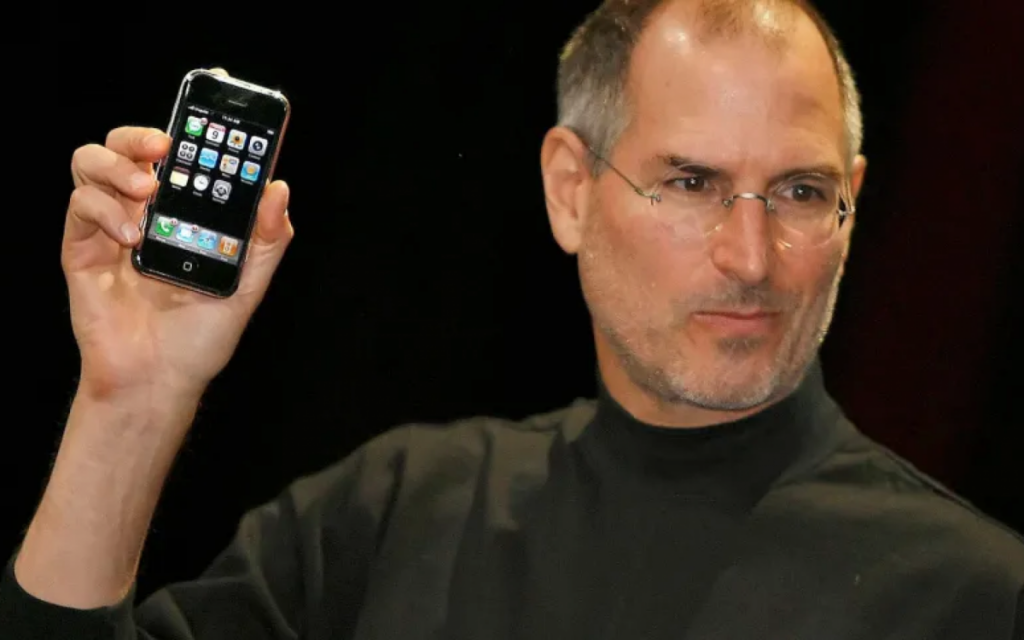

iPhone – O ano de 2007 marcou o lançamento do iPhone pela Apple, inaugurando uma era de smartphones que trouxe a computação para a palma da mão das pessoas, combinando funcionalidades de computador com comunicação móvel.

Windows 7 – O ano de 2009 trouxe o lançamento do Windows 7 pela Microsoft, apresentando uma série de melhorias significativas de usabilidade e a experiência do usuário.

Computação Quântica – Em 2015, a IBM deu um passo significativo ao lançar o primeiro computador quântico de acesso público via nuvem. Este evento permitiu a primeira experiência quântica para muitas pessoas (cientistas e estudiosos) à alta capacidade de processamento e resolução de problemas complexos que desafiam os supercomputadores tradicionais.

Informática Molecular – A DARPA, em 2017, anunciou uma iniciativa inovadora que visa explorar o potencial da informática molecular. Essa abordagem pioneira utiliza moléculas como componentes de computação, desafiando os limites convencionais da tecnologia e abrindo portas para novos avanços em campos como medicina, biologia e processamento de dados.

Confira toda a linha do tempo em: https://www.computerhistory.org/timeline/

Informática nos Dias Atuais: Desafios e Inovações do Século XXI

A partir de 2020, a informática tem desencadeado um ritmo acelerado de transformação em praticamente todos os aspectos da vida moderna. Vale a pena no Dia da Informática, citarmos tecnologias, como: Machine Learning, Internet das Coisas (IoT), Inteligência Artificial (IA) e outros estão redefinindo como interagimos com o mundo digital.

Inteligência Artificial: O Caminho para a Automação Inteligente

Apesar de ser o assunto preferido dos filmes de ficção científica, as IAs já são uma realidade no nosso dia a dia. A Inteligência Artificial (IA) refere-se à capacidade de sistemas computacionais executarem tarefas que normalmente exigiriam inteligência humana. Ela está presente em chatbots, assistentes por voz e algoritmos de recomendação, melhorando interações e eficiência de atividades. Além disso, em áreas como medicina e indústria, a IA está revolucionando diagnósticos, otimizando processos de fabricação e impulsionando a pesquisa científica. Um ótimo exemplo é o ChatGPT lançado em 2022 pela OpenAI, um software capaz de criar histórias, responder a dúvidas, aconselhar, resolver problemas matemáticos e muito mais — tudo isso utilizando uma linguagem fluida e natural, semelhante à humana.

Machine Learning: Uma Revolução na Computação

O “Aprendizado de Máquina”, em português, é uma vertente da Inteligência Artificial (IA) que capacita os sistemas computacionais a aprenderem e melhorarem com base em dados, sem programação explícita. Esse avanço revolucionou a forma como máquinas entendem padrões e tomam decisões. Ao analisar grandes volumes de dados, os algoritmos de Machine Learning podem fazer previsões precisas e automatizar tarefas complexas. Seu impacto abrange desde assistentes virtuais inteligentes até diagnósticos médicos mais precisos, redefinindo setores inteiros e promovendo a eficiência.

Internet das Coisas: Conectando o Mundo Digital e Físico

A Internet das Coisas (IoT) envolve a conexão de objetos cotidianos à internet, permitindo a troca de informações e a automação de tarefas. Com dispositivos interconectados, desde eletrodomésticos até veículos, a IoT está transformando como interagimos com o ambiente ao nosso redor. Ela possibilita casas inteligentes, cidades autônomas e monitoramento remoto de saúde, resultando em maior conveniência, eficiência e tomada de decisões informadas.

Porém, a importância desta tecnologia transcende a mera conveniência, pois a IoT está remodelando atividades cotidianas oferecendo oportunidades promissoras para uma melhor qualidade de vida e um futuro muito mais conectado e inteligente.

Conectividade 5G: Na Era da Velocidade e Latência

A conectividade 5G marca um salto na velocidade e eficiência das redes de comunicação móvel. Oferecendo taxas de transferência de dados muito mais rápidas e menor latência, o 5G impulsiona a adoção de IoT, realidade virtual, transmissões de alta qualidade e outros aplicativos intensivos em dados. Essa tecnologia é um alicerce essencial para a expansão da IoT, proporcionando a capacidade de conectar uma ampla gama de dispositivos em tempo real.

Big Data: Desvendando os Dados

Big Data refere-se à coleta, processamento e análise de grandes volumes de dados. Com o crescimento exponencial da geração de dados, essa tecnologia se tornou essencial para tomar decisões informadas. Empresas e instituições usam análises de Big Data para identificar tendências, comportamentos do consumidor e padrões ocultos, impulsionando a tomada de decisões estratégicas e aprimorando produtos e serviços.

À medida em que a sociedade se relaciona com as novas tecnologias de informática, acompanhamos de perto um cenário de inovação e transformação sem precedentes. Essas tecnologias estão interligando nosso mundo físico e digital, impulsionando a eficiência, redefinindo setores inteiros e aprimorando a qualidade de vida.

Entretanto, com o poder dessas tecnologias vêm desafios e responsabilidades. A segurança cibernética, a privacidade de dados e as preocupações éticas se tornam questões cruciais para abordar. Enquanto aproveitamos as vantagens dessas inovações, é essencial implementar práticas robustas para resguardar informações pessoais, assegurando que o progresso tecnológico seja acessível e inclusivo.

Conclusão

Das engrenagens da “Máquina de Leibniz” à toda tecnologia disponível, a informática tem sido a força motriz por trás das mudanças que redefiniram nossa existência. No entanto, o potencial não está apenas no passado, mas também no horizonte infinito de possibilidade à nossa frente.

A SoftSell, como uma empresa comprometida em oferecer soluções inteligentes para negócios e pessoas, destaca a importância de investimento na área de TI, pois com todos estes avanços tecnológicos, contar com um parceiro para impulsionar as estratégias e adequar as necessidades é essencial para a sobrevivência no mundo atual.

Diante dos desafios e possibilidades que apresentamos nesta linha do tempo, podemos vislumbrar um futuro em que a informática rompe diversas barreiras. A convergência de novas tecnologias e outras inovações, promete uma nova era de avanços revolucionários, desde diagnósticos médicos mais precisos até a automação de processos complexos. Nesse percurso, o Dia da Informática nos insere em uma jornada em direção a um amanhã mais brilhante, mais conectado e mais inteligente. Que a humanidade prossiga explorando e inovando em direção a esse futuro emocionante.

Confira nosso último post: Fim do Windows Server 2012, como fica a sua empresa?